皆さん、こんにちは。

見習い王子です。

さて、今回はブログ運営のお話です。

先日の記事+Twitterで嘆いたのですが…(;´・ω・)

ここ数日アクセスが下がっていると思ったら、最近の記事がグーグル先生にインデックスされていないようです…。

はて?調べてみると

「robots.txtによってブロックされています」

とかなんとか…(;'∀')#ブログ運営 #グーグルサーチコンソール #googlesearchconsole pic.twitter.com/KiM7VuGH3I— 見習い王子 (@minaraioji) March 13, 2019

目次

インデックス登録エラーが依然として解決しない!

グーグルサーチコンソールのカバレッジを見てみると、535のエラーが起きていることが判明!(;’∀’)

エラー内容は3つ。

・送信されたURLにnoindexタグが追加されています

・送信されたrobots.txtによってブロックされました

・送信されたURLのクロールに問題があります

まず1つ目のnoindexタグのエラーについて

あえてnoindexタグを入れているページがあり、それで表示されてしまっているので大きな問題ではないでしょう。

次にrobots.txtの件は…

知りませんでした。

はて?こんなのあるんだ?(;’∀’)

robots.txtというファイルを作って、色んな検索エンジン等のクロールに指示を出す事ができるようです。

グーグルには検索してもらいたいけど、別の検索には引っかからなくさせる制限をかけたり、管理ページなど検索エンジンにここはチェックしにこなくていいよ!とページ単位で設定もできます。

しかし、知らなかっただけに何の設定もしておりませんが、ブロックされたとは一体どうなってるんでしょう?

調べてみると私の使っているCMS「WordPress」は自動的にこれを作ってくれている模様。

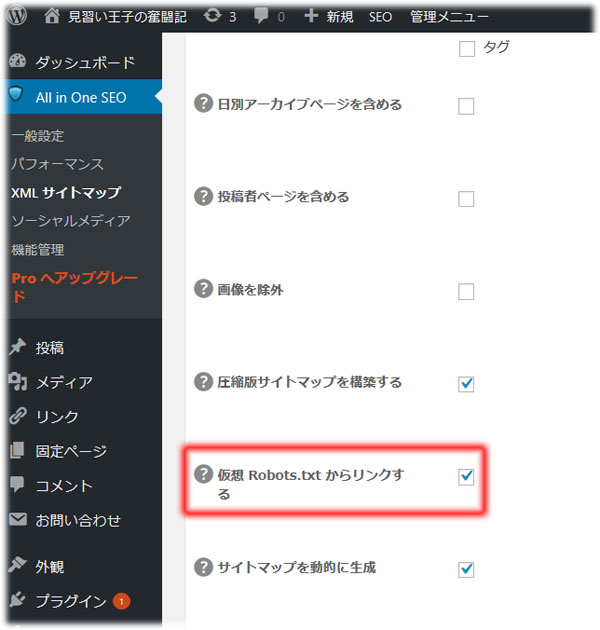

さらに私が導入しているプラグイン「All in One SEO」にも「仮想 Robots.txtからリンクする」機能も意味も分からず使っていました。

それで、色々調べてみてもRobots.txtがブロックしているページも無いし、robots.txt テスターを使ってもエラーはないし、なんでやねん!状態です(ノД`)・゜・。

とりあえずどの検索エンジンからでも見れて、どのページも許可する設定でrobots.txtを自作し、Webサーバーへ設置。

それと同時に上記プラグインの仮想Robots.txtからリンクするのチェックを外して様子を見る事にしました。

3つ目の送信されたURLのクロールというのが一番ネック?

要は、

robots.txtに許可されていて、サイトマップの指示通りに見に行った(クロール)けど、ページ見れなかったよ!

って事だと思うんですよね。

いや見れてますし(;´・ω・)

該当のURLで…。

ここは対策方法がまったくわからんです…。

Webサーバーが一時的にダウンしていた瞬間にクロールしてきて、ページが見つからないってことになったのではないかと思いたいのですが…。

それならば放置しておけば次のクロール時にエラーがなくなり正常になるかも?

と不安と期待を抱きながら待とうと思います。

いやしかし、約300記事(noindexエラーの部分以外)がグーグル検索のインデックスから外されるというのはかなり痛手ですね…。

何とかしなければ…!

コメント

がんばりやー身体には気ぃつけるんやでー

>匿名さん

ありがとうございます!

とりあえずの応急処置はできて改善はできて参りました。

あとは・・・最近体調が悪いのでしっかり休息もとりたいですね(^-^;